Blog

PFNフェローの丸山です。

1月9日に、機械学習の研究開発と利用に関わる3研究会(人工知能学会 倫理委員会、日本ソフトウェア科学会 機械学習工学研究会、電子情報通信学会 情報論的学習理論と機械学習研究会)は「機械学習と公平性に関するシンポジウム」を一橋講堂で開催しました。このシンポジウムは、これら3研究会が、前月12月10日に出した機械学習と公平性に関する声明を受けて実施したものです。平日の夜に関わらず、350名ほどの方々が参加してくださいました。

MicrosoftのチャットボットTayが不適切な発言をするようになってしまった事件、Amazonが採用に機械学習を利用しようとして、女性に不利益になることに気づき利用を断念した件、など、機械学習の利用が想定しなかった差別を生むことに以前から懸念がありました。最近になって、ある「AI研究者」が自身の差別的発言は機械学習が原因であるかのような主張をしました。これを見た現場の機械学習研究者から「研究者コミュニティとして、我々の立場を発信すべき」という意見が出ました。それで、関連する研究会の方々にお声がけして声明を用意し、今回のシンポジウムに至ったものです。

今回のシンポジウムは、機械学習研究者の立場から産総研の神嶌さん、技術と向き合う社会の立場から東大の佐倉先生、それに研究者の倫理の立場から同じく東大の江間先生にご登壇いただき、それぞれの立場からの見方をご講演いただきました。講演資料と動画はシンポジウムのページを御覧ください。ここでは、それぞれの講演で私の感じたことをまとめておきたいと思います。

機械学習と公平性

機械学習の公平性については、近年急速に研究が進んでいます。そこでは公平性をどのように定義しようとしているのでしょうか。機械学習は説明変数(神嶌さんのスライドでは「特徴」)を入力として目的変数(結果)を推測します。説明変数のうち、性別・国籍・宗教など公平性に関わるものをセンシティブ特徴S、そうでないものをノンセンシティブ特徴Xと呼ぶことにしましょう。推測された目的変数をYとすれば、公平性はS, X, Yの間の形式的な関係で定義することができます。

公平性の1つの定義は、手続きとして捉え、Yを得るのにセンシティブ特徴Sを使わない(Y=f(X)という計算を行う)、というものです。これをここでは手続き公平性と呼びましょう。例えば「応募書類に国籍は明示しない」はこの例です。国籍情報が得られないので、国籍に基づく差別は起きない、という考え方です。決められた手続きを守ればよいので単純です。

もう1つの定義は、結果的な公平性で、例えば国籍によって採用率が異なっていなければ(すなわちある国籍を持つことと、採用されることが統計的に独立ならば)OK、と考えるものです。これを結果公平性と呼びましょう。残念ながら、手続き公平性と結果公平性は両立しません。結果公平性を検証するためには、センシティブ特徴を積極的に使わなければならず、そのこと自体が手続き公平性に反するからです。

このように、一言で「公平性」と言っても、異なる定義があることがわかります。これに加えて、公平性を個人かそれともグループのレベルで考えるか、予測結果の精度が特定の人に不利にならないか、など様々な観点があります。

神嶌さんがこの講演で指摘されたのは、機械学習の言葉で公平性を語れば、公平性の様々な側面が明確になってくるので、私たちの公平性に関する理解をより明確にすることができる、ということです。加えて、機械学習を用いたシステムならば、与えられた基準に照らしてシステムが公平であるのかをより簡単に検証することができますし、問題があれば修正することもできます。一方、公平性の問題が採用担当者の無意識なバイアスから引き起こされている場合には、それを検出したり修正したりするのは困難です。

進化的合理性

公平性の概念をより明確にし、またそれに基づいて公平なシステムを作るのに機械学習が貢献できるのはわかりましたが、上の議論には1つ大きな仮定がありました。それはセンシティブ特徴は何か、が事前に決められていなければならないことです。例えば採用においてセンシティブ特徴とすべきなのは何でしょうか。日本国憲法第14条には、国民は「人種、信条、性別、社会的身分又は門地によって」差別されない、という記述がありますから、これら5つについてはセンシティブ特徴であると思ってよいでしょう。最近は性的指向や障がいの有無もセンシティブ特徴と考えられることが多いようです。学歴や容姿、居住地、既往症の有無などはどうでしょうか。だんだんややこしくなりそうです。

難しいのは、多くの場合、特定の問題が起きたとき事後になって初めて「やはりこれはセンシティブ特徴だったはずだ」ということがわかることです。リクナビ問題の場合、過去の類似の応募者の内定辞退率が問題になりました。この内定辞退率算出に使われる説明変数は学生のWeb訪問履歴などだったのだと思いますが、これらはセンシティブ特徴でしょうか。

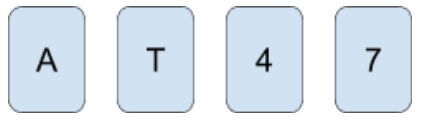

その疑問に光をあててくれたのが2番めの講演で、科学技術と社会の接点を研究されている佐倉先生のものでした。佐倉先生は、ウェイソン選択問題を例にして、人がどのような推論が得意か、ということを話されました。下記のようにカードが4枚あります。カードの片面にはアルファベット、その反対面には数字が書かれています。「母音の裏は必ず偶数である」というルールを検証するには、どのカードを裏返せばよいでしょうか。

答えは「Aと7のカード」なのですが、多くの人は「Aと4」と答えるそうです(かくいう私も、最初にこの問題を見たときにはそのように考えました)。Aの裏が偶数であることは確認する必要がありますが、4の裏が母音であろうが子音であろうがルールには抵触しません。一方、7の裏は子音でなくてはならないので、こちらを確認する必要があります。合理的に考えれば明らかなのですが、人間の思考はなかなか合理的にはならないようです。

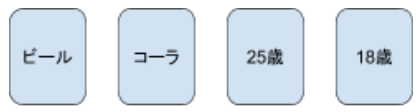

興味深いのは、同じ問題を別の表現にしてみた場合です。今回は、カードの1面に飲み物の種類(ビールかコーラか)、反対面に年齢が書かれています。「ビールを飲む人は20歳以上」というルールが成り立つかどうかを調べるには、どのカードをめくってみればよいでしょうか。今度は、正しく「ビールと18歳」と答える人が多いのではないでしょうか。

しかし、問題の論理的な構造は先程と全く同じです。違うのは、母音・子音/偶数・奇数という中立な概念ではなく、アルコール飲料を未成年者が飲んでよいか、という社会規範に関わる問題設定になっていることだけです。数多くのウェイソン選択問題のバリエーションについて研究され、その結果知られているのは、「資格を認められない限り正当には得られない利得」について、人々は一貫して高い正答率を示す、ということだそうです。つまり「他人がずるをしている」ことについては、私たちは極めて鋭敏に反応するのです。

佐倉先生は、これを人間の進化的合理性と呼んでいます。人間は常に中立な合理的思考をするわけではないが「社会の中で自分だけが損をしないように」という問題に関しては合理的な思考を行う、という意味です。人間の持つこのような社会認知特性は、公平性の問題に対しても同様に現れる、ということを佐倉先生はおっしゃりたかったのだと思います。すなわち、人々は何が公平かについて事前に定まった価値基準を明示的に持っているわけではないが、ひとたび不公平な事象を見つけると、極めて鋭敏に「それは不公平だ」と指摘する能力を持っているのです。

このような鋭敏な思考を人間はどのように身につけたのでしょうか。それは、私たちが生まれてからずっと社会の中で育ってきたからです。逆に言えば、社会の中で揉まれて育つことのない機械には、このような能力を身につけることは困難です。佐倉先生は、だから、差別や公平性のような社会規範に関する価値判断については、機械に任せることはできず、その能力に長けた人間が行うべき、とおっしゃっていました。

日本の立ち位置

江間先生の講演は、世界で公平性の議論がどのように行われているか、その中で日本の立ち位置はどのあたりにあるのか、という内容でした。公平性は、実は「AI」一般の倫理の議論の中の1側面に過ぎません。安全性やプライバシー、遵法性や社会の持続可能性など、いろいろな側面が議論されています。

江間先生は、集まった350名の聴衆にバックグランドを尋ねました。私のみるところ、機械学習の研究者が40-50名、社会学系の方が10名くらい、その他のほとんどは企業の方で、機械学習をビジネスに使おうという人たちでした。パネル討議での質問でも、公平性の問題が、企業で機械学習を使う際にどのようなリスクになるのか、そのリスクを避けるにはどうしたらよいのか、という興味が大きいようでした。

江間先生のご講演の中で印象に残ったのは、国連が出す文書の根底には「人権」を尊重する価値観がある一方、日本の議論はSDGsなどの政策を実現するためのルールとしての議論が多い、ということでした。日本はあまりはっきりした価値観を持たない、言い換えれば価値観に関して柔軟な考えを持つ社会、といえるのかもしれません。それが良いことかどうかはわかりませんが、1つの特質と見る必要があるかもしれません。

また、もう1つ大事な問いかけとして、いろいろな問題を「トレードオフの問題」として安易に片付けることに対して、それでよいのか、という疑問がありました。公平性と経済合理性はトレードオフだから、どちらかを諦めなければならない、というのは本当だろうか、トレードオフを乗り越えて両立する方法を考えるのが研究者の心構えではなかろうか、という江間先生流の挑戦だったのだと思います。これから心していきたいと思います。

研究者として考えること

今回のシンポジウムを通して、私たち研究者が社会の中でどのような責任を果たしていくか、についてより深く考えることができました。

私は昨年暮れに、人工知能研究者として私たちがすべきことという記事を書きました。この中で述べたことは3点です。

- 技術を正しく伝えること

- 適切に怖がること

- 見たくないものを、見ること

公平性に関しても同じことが言えると思います。

このような議論は、往々にして深い考察を必要とし、面倒なものになりがちですが、私たちは、そのような新たな問いから目をそらさずに、誠実に取り組まなければならないと思います。

Tag