Blog

Preferred Networksの子会社のPreferred Elements(以下、PFE)では、2月から1,000億(100B)パラメータ規模のLLM「PLaMo-100B」の開発を行っていました。5月に事前学習部分を終え、以降は後段となる事後学習を行っていました。今回の記事では、後段の事後学習の取り組みを紹介します。

事後学習を終えたPLaMo-100B-Instructの性能は、Jasterという日本語性能評価ベンチマークでGPT-4を超え、日本固有の知識を問うRakuda BenchmarkでもGPT-4の性能を超えることが確認できました。以下のプレスリリースもご覧ください。

PFEが開発する大規模言語モデルPLaMo β版の無料トライアルの申込受付を開始

この「PLaMo-100B」の開発は、日本の生成AI基盤モデル開発力向上を目指す政策GENIACにおいて、国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)が実施する「ポスト5G情報通信システム基盤強化研究開発事業/ポスト5G情報通信システムの開発」による計算資源の提供支援を受けて実施しました。

事後学習とは?

大規模言語モデル(LLM)の開発には、事前学習に続いて事後学習 (post-training) というプロセスが必要となります。大量のテキストのNext token predictionを行う事前学習によって、LLMの内部では様々な言語の文法理解や世界の知識を学ぶことができますが、事前学習のみを終えたモデルからはこれらの知識を人間の意図に沿って効率よく取り出してくることが困難です。事後学習により、事前学習で獲得した能力をどのように取り出すかを学ばせることによって初めて人間が実応用アプリケーションで使いやすいものとすることができます。

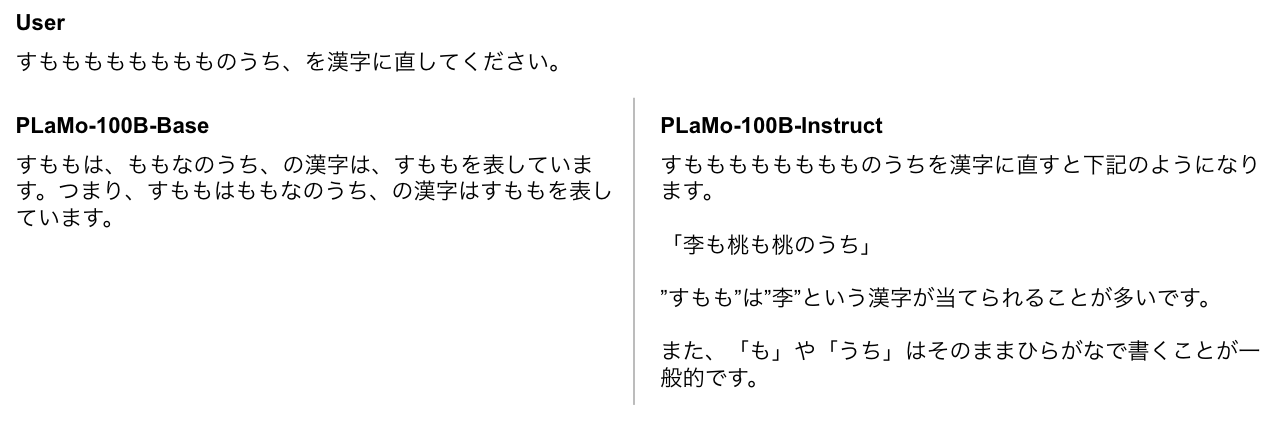

以下の図1を見てください。有名な早口言葉を漢字で書くとどうなるかというユーザーの指示に対して、事後学習を行っていないPLaMo-100B-Baseモデルはきちんとした回答ができていませんが、事後学習を終えたPLaMo-100B-Instructモデルはきちんとユーザーの意図を汲んだ回答ができています。

図1:事後学習前後での出力の比較

図1:事後学習前後での出力の比較

事前学習を宝石の原石を作り上げる作業だとすると、事後学習はその宝石を磨き込む作業に相当すると例えることができるかもしれません。原石の状態では輝きをもちませんが、事後学習によって磨きこむことで、特定の用途に使いやすい実用上の価値が生まれます。

今回、PFEでは事前学習からフルスクラッチで自社で開発したモデルであるPLaMo-100Bに対する事後学習を行うことで、どのようなデータを用いて、どのように事後学習を行うことができるかのノウハウを得る事ができました。このようにモデルの構築を学習過程・データまで制御できるということは、今後LLMを様々なアプリケーションに組み込んでいく上では重要であると考えています。

学習方法

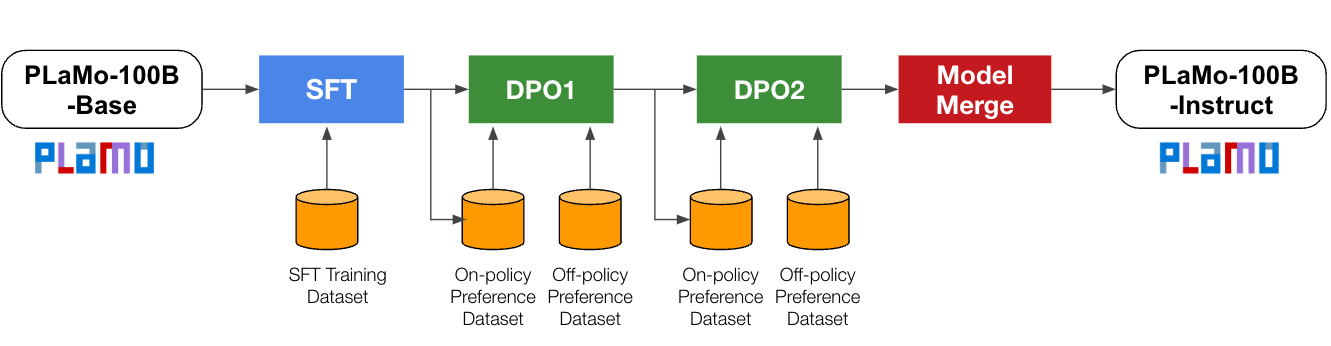

今回の事後学習では、Supervised Finetuning (SFT)とDirect Preference Optimization (DPO)アルゴリズムを使用しました。後述するように、SFT → Iterative DPOという形の学習パイプラインをとりました。また学習後のさらなる汎化性能向上を目的として複数の学習済みモデルによるModel Mergeの手法も取り入れています。図2に学習パイプラインの概要を示します。

図2:学習パイプラインの概要図

Supervised Finetuning (SFT)

SFTでは、「LLMに対する質問」と「LLMに期待する回答」のペアからなるデータセットを用いて教師あり学習を行います。数学の問題に答えるタスクであれば「問題」と「解答」のペア、チャットの回答タスクであれば「ユーザーのプロンプト」と「理想的な回答」のペア、というように様々なタスクをこの形式のデータセットにすることができます。多様なタスクと高品質な回答で構成されたデータセットを用いることで、LLMの下流タスクでの性能が向上することが期待されます。

訓練は事前学習と同様にNext Token Predictionで行いますが、SFTでは特に回答部分の生成を調整するのが目的であるため、LLMに入力された文章のうち回答部分のみでロスを計算するという工夫が行われることがあります。事前に行った実験ではこの違いによる性能差は確認できませんでしたが、質問に攻撃的な表現などが含まれていた場合にそれを学習してしまう可能性があることなどを踏まえ、今回の学習では回答部分のみでロスを計算しました。

SFTでは、様々なタスクの訓練データを適当な割合で混合して一度に学習するのが一般的です。しかし、先行研究のNemotron-4では、複数のタスクを同時に学習すると競合がおこり、各タスクのサンプル割合を調整しても両立させることができなかったと報告されています。特にCodingに関してこの傾向が顕著で、対策として、Codingに特化した1st Stageと様々なタスクをカバーする2nd Stageの2段階に分けてSFTを行う方法が提案されています。我々の実験でも、数学に関して同様の現象が確認されており、先行研究に倣って、数学に特化した1st Stageと多様なタスクの2nd Stageに分けてSFTを行いました。

Direct Preference Optimization (DPO)

DPOは Rafailov et. al (2024) により提案されたアルゴリズムです。同じ質問に対する2つの回答例のうちどちらがより好ましいかラベル付けされたデータから人間の選好 (preference) を学習させ、モデルがより好ましい回答をするように促します。

DPOの学習に用いるデータとしては、Anthropic/hh-rlhf や nvidia/HelpSteer2 など、既存のLLMが生成した回答や人間が書いた回答にラベル付けした公開データセットが使われることが多いですが、学習対象のモデル自体に複数の回答候補を生成させ、その回答に対してラベル付けを行うことでデータを作成することも可能です。前者の設定は、回答を生成したモデルと学習対象のモデルが異なるため方策オフ (off-policy) 、後者の設定は方策オン (on-policy) と呼ばれます。方策オンのデータを用いることで、そのモデルが出力しやすい回答に対して選好のフィードバックが得られるため、学習効率が良くなると考えられ、 先行研究でも有効性が研究されています (Tajwar et al., 2024)。中間的な手法として、SFTデータセットの教師回答の方が学習対象のモデルで生成した回答より好ましいとみなし、それらをペアにしたデータセットを生成するSPINという手法も提案されています。また、学習対象のモデルを使ってデータ生成を行う場合、データ生成とDPOの学習を交互に繰り返すことも可能になり (Iterative DPO)、先行研究で1回のみのDPOより有効であることが報告されています (Xu et al., 2023, Dong et al., 2024)。

我々の今回の学習では、世の中に公開されている高品質な選好データセットも活用しつつ、方策オンのデータセットを使ったIterative DPOの利点も得るために、公開データセット、過去のPLaMo-100Bのスナップショットで生成した回答にラベル付けした生成データセット、SPINによるデータセットを組み合わせて、SFT後に2段階のDPOの学習を行っています。データセットの生成方法については、データ生成のセクションでより詳しく説明しています。

Model Merge

モデルマージは、複数のモデルを合体させて改良を狙うもので、さまざまな手法があります。先行研究のLlama-3.1においても複数のモデルの平均を使用していることが報告されています。今回はモデルマージのなかでも簡単な手法であるSLERPにより二つのモデルの中点をとる方法を使いました。

今回、DPOの結果には訓練データの組み合わせなどの違いにより数個の最終候補がありました。その中で特徴的な2つのモデルをマージすることで、良いところをある程度兼ね備えたモデルを作ることができました。

データ生成

事後学習を行うためには、ユーザーの質問に対してどういった回答を行うのが望ましいのかがわかるような”多様で高品質なデータ”が必要となります。事後学習を行った初期の研究であるInstructGPTでは、多数のアノテーターを雇い、ユーザーからの質問に対してLLMはどのように回答をすべきか?ということを定義するためのデータセットを作成しています。しかし、LLM開発が進んでくるに従って、Constitutional AIやSelf-InstructなどLLM自身に事後学習用のデータセットを構築させる取り組みも盛んになってきました。

人手でデータを作成していく方法にはコストがかかり大企業との競争優位性が低いこと、またプロジェクト・アプリケーションごとに変わりうる事後学習の目標に柔軟に対応できる技術基盤の開発を目標として、PFEではGENIACプロジェクトに取り組み始める2月時点で、スケールするデータ生成手法の開発に注力する方針を立て、開発を進めてきました。

実際の事後学習においては、以下に示すような全ての方法を試行錯誤しました。

- Publicなデータの使用

- プログラムによるデータ生成

- LLMによるデータ生成

なお、本プロジェクトにおいては、商用利用が認められていないデータや、GPT-4・GPT-3.5などのProprietary modelの出力は使用していません。また、GENIACの要件でJasterの訓練データの使用が禁止されているためJasterの訓練データも使用していません。

Publicなデータの使用

英語ではoasst2やhh-rlhfなど、日本語ではichikara-instruction (商用利用は有償)など、最近は高品質な事後学習用のデータセットも公開されています。公開データセットは日々使えるものが増えており、今回のプロジェクトでも期間中に公開されたデータも注視しながら様々なデータセットに対して実験を行いました。

プログラムによるデータ生成

算数・数学の問題を正確に解くことを目的に、計算を含む問題のテンプレートを作り、数値を変えてデータセットを生成しました。今回の学習用に独自に生成した数学データセットは機械学習を用いていません。手作業で作れる問題テンプレートの数には限界があり、値のみが異なるデータが大量に入ることになるので過学習が心配になりますが、事前の学習実験や以下のような考察から大丈夫だろうと判断しました。まず、LLMが計算結果を生成するタイミングでは、自然な正解は通常1つしかないためトークンの分布がほぼ deterministic になるまで学習することは意図通りです。また、数式以外の地の文も定型文が多いと考えられます。さらに問題の数値が違うだけといっても、足し算での繰り上がりの有無、分数の計算で結果が約分できるか、連立一次方程式でどの変数から消去すべきかなど多少の多様性が自然に生まれます。

既存の機械学習によらないデータセットとしては、たとえば Hendrycks et al., 2021 内の AMPS pretraining corpus や Saxton et al., 2019 などもありますが、数式のTeXが人工的だったり回答が値のみだったりする点では事後学習用データとしては改善の余地があり、また日本語の数学データを増やす目的でも独自にも生成することにしました。数学関係のデータセット群は事前学習にも用いていますが、事後学習用には指示応答のフォーマットを適用する他、このようなデータセットごとの性質を考慮に入れて事前学習と異なる比率で組み合わせています。

LLMによるデータ生成

質問応答データセットについては、Self-Instruct を参考に生成しました。GPT で生成する Self-Instruct のアルゴリズムをそのまま使うのではなく、PLaMo-13BなどのサイズのLLMでも生成できるように工夫しました。たとえば、いきなり質問文を生成しようとするとうまく生成できなかったため、先に短いタイトルを生成させるステップを増やしました。

また、開発中のPLaMo-100Bを用いて、収集・生成したデータセットを日本語に翻訳する取り組みも行いました。事後学習に利用可能な日本語のデータセット、という観点でみると、公開されている商用利用可能なデータは非常に限られており、学習に十分な量や多様性を確保するのが難しいです。自分たちでデータを生成する場合でも、OpenなLLMの多くが英語での利用を念頭に開発されており、高品質な日本語の応答を生成するのは英語に比べて難しいというのが現状です。PLaMo-100Bを用いた翻訳によって事後学習時の高品質な日本語のデータ量が増え、Japanese MT-Benchなど日本語の生成タスクにおいて性能向上が確認できました。

学習途中のPLaMo-100Bを用いたPreferenceデータ生成

今回はRLHF Workflowを参考に、事後学習途中のPLaMo-100Bを用いて同じPromptに対して8通りの回答を生成し、それら回答についてスコア付けを行い最もスコアが高いものをchosen、低いものをrejectedとしてPreferenceデータの生成を行いました。回答のスコア付けにはOpenなLLMを用い、LLM as a Judge形式でスコア付けする方法とReward modelを用いてスコア付けする方法の双方を実験しました。

本データ生成においては、Promptのみが存在すればよく教師となる回答例は必要ではありません。そのため、chatbot_arena_conversationsのようなUser promptのみが商用利用可能な形で公開されているデータセットも有効活用する事ができます。なお、LLMの推論を行う回答生成においてはvLLMを用いた高速化を行いました。

評価方法および評価結果

モデルの評価にはGENIAC 1.0でWeights & Biases社により運用されたベンチマークであるllm-leaderboardのg-leaderboard branchを用いて、Jaster・MMLU・MT-Benchを計測しました。また社内で作成した評価コードによりRakuda Benchmarkも計測を行いました。

Jaster

日本語の言語理解能力を測定するベンチマークで、llm-jp-eval リポジトリのコードを用いて評価が行われます。GENIACプロジェクトにおいては、g-leaderboard branchにて特有のカテゴリセット(NLI, QA, RC, MC, MR, FA の 6 カテゴリ)で評価されています。それぞれのカテゴリの意味や設問例などはNejumi LLMリーダーボードNeoをご参照ください。

本ベンチマークでは、設問の際に質問および解答例を例示する4-shotsと、例示しない0-shotでの回答性能が計測されています。

| Model Name | AVG | FA | MC | MR | NLI | QA | RC |

| GPT-4 (0125 Preview) | 0.7222 | 0.2546 | 0.96 | 0.97 | 0.772 | 0.5685 | 0.8084 |

| GPT 3.5 Turbo | 0.5668 | 0.1828 | 0.61 | 0.77 | 0.59 | 0.4294 | 0.8183 |

| Swallow-70b-instruct-hf | 0.5755 | 0.1752 | 0.59 | 0.71 | 0.642 | 0.48 | 0.8559 |

| PLaMo-100B-Base | 0.5415 | 0.1851 | 0.83 | 0.28 | 0.682 | 0.4256 | 0.8463 |

| PLaMo-100B-Instruct | 0.7378 | 0.5791 | 0.95 | 0.78 | 0.838 | 0.3939 | 0.8858 |

表1:Jaster 0-shotの評価結果

※PLaMo-100B-Instruct は社内で評価を実施、他のモデルはWeights & Biases社の実施した評価の結果

| Model Name | AVG | FA | MC | MR | NLI | QA | RC |

| GPT-4 (0125 Preview) | 0.7724 | 0.4052 | 0.95 | 0.98 | 0.806 | 0.6225 | 0.8707 |

| GPT 3.5 Turbo | 0.6564 | 0.355 | 0.9 | 0.84 | 0.544 | 0.4226 | 0.8765 |

| Swallow-70b-instruct-hf | 0.6755 | 0.3653 | 0.9 | 0.77 | 0.506 | 0.6339 | 0.8779 |

| PLaMo-100B-Base | 0.6786 | 0.3045 | 0.93 | 0.61 | 0.71 | 0.6335 | 0.8839 |

| PLaMo-100B-Instruct | 0.7750 | 0.5917 | 0.96 | 0.80 | 0.856 | 0.5610 | 0.8812 |

表2:Jaster 4-shotsの評価結果

※PLaMo-100B-Instruct は社内で評価を実施、他のモデルはWeights & Biases社の実施した評価の結果

表1, 2を見るとわかるように、事後学習を行ったPLaMo-100B-Instructはベースモデルからその性能をさらに引き上げて、平均スコアではGPT-4のスコアを超える結果となりました。今回はJasterの訓練データセットは使用していませんが、FLANの論文や先日公開した技術ブログ「PFEの開発したLLMのPLaMo-100Bを用いた金融ベンチマーク評価と結果の分析」でも紹介されているように、様々な問題形式に対してどのような回答形式が求められているか?といったことを学習することで事前学習時に得た知識の活用方法を習得し、性能を上げる事ができたと考えられます。この結果により、日本語を重点的に学習したPLaMo-100Bは高い日本語の基礎言語理解能力を持つことを確認する事ができました。

唯一GPT-4と差がついているのが MR (Mathematical Reasoning) カテゴリです。前述したように事後学習時に数学のデータセット構築を行い、大きな量の追加学習を行ったことにより、ベースモデルからはスコアが大きく向上しましたが、100%近い正答率の達成は事前学習時にたくさんの例を見て汎化するレベルまで計算能力を身につけていないと難しい事が示唆されます。

MT-Bench

MT-BenchはLLMの会話応答能力をみるベンチマークで、8カテゴリ(Writing・Roleplay・Extraction・Reasoning・Math・Coding・STEM・Humanities)における質問の応答品質を測定します。回答は自由記述式の会話となるため、その点数付けをルールベースでは行う事ができません。代わりにGPT-4などのLLMを評価者として用いてスコアをつける方法(LLM-as-a-Judge)を用いて点数付けを行います。元のベンチマークは英語ですが、Stability AI社が日本語版を作成し、Japanese MT-Benchとして公開しています。

GENIACプロジェクトでは英語・日本語双方のMT-Benchスコアを計測していますが、表3は日本語版であるJapanese MT-Benchのスコアを記載します。

| Model Name | AVG | coding | extraction | humanities | math | reasoning | roleplay | stem | writing |

| GPT-4 (0125 Preview) | 8.925 | 9.1 | 8.5 | 8.55 | 8.65 | 8.25 | 9 | 9.8 | 9.55 |

| GPT 3.5 Turbo | 8 | 8.4 | 8.65 | 9.75 | 5.15 | 6.35 | 8.75 | 8.5 | 8.45 |

| Mixtral-8x7B-Instruct-v0.1 | 6.975 | 6.65 | 8.15 | 8.5 | 5 | 6.05 | 6.4 | 8.4 | 6.65 |

| Swallow-70b-instruct-hf | 4.381 | 3.35 | 5.7 | 4.8 | 1.45 | 3.75 | 5.85 | 5.85 | 4.3 |

| PLaMo-100B-Base | 5.469 | 3.85 | 4.65 | 7.6 | 3.95 | 2.55 | 8 | 7.7 | 5.45 |

| PLaMo-100B-Instruct | 7.781 | 4.95 | 7.7 | 9.75 | 4.9 | 7.35 | 9.25 | 9.1 | 9.25 |

表3:Japanese MT-Bench の評価結果

※PLaMo-100B-Instruct は社内で評価を実施、他のモデルはWeights & Biases社の実施した評価の結果

結果を見ると、PLaMo-100B-Instructは平均得点で7.781点となり、GPT-3.5に近い性能を出す事ができています。ベースモデルでの5.469点から比較すると大幅な向上となっており、期待通り、事後学習を行う事でその会話応答性能を大きく向上させる事ができています。

カテゴリ別でみると、humanities, stem, writing, roleplayのカテゴリにおいて特に高いスコアが出ており、自由記述式なものや創作的な要素を必要とするようなの会話応答においては優れた能力を持つ事が確認できました。表4にhumanitiesカテゴリでの応答例を示します。

| Turn | User | PLaMo-100B-Instruct | Score |

| 1 |

日本でビジネスを行う際のビジネスマナーについて説明してください。 |

日本でビジネスを行う際には、日本独自のビジネスマナーが存在します。以下に、その一部をご紹介します。 ・名刺交換 日本では、名刺交換は非常に重要なビジネスマナーの一つです。名刺交換の際には、名刺を両手で受け取り、相手の目を見て挨拶を交わします。また、名刺を受け取る際には「頂戴いたします」と言い、相手の名刺を丁寧に扱います。 ・挨拶 日本では、挨拶を非常に重視します。ビジネスの場では、「おはようございます」「こんにちは」「こんばんは」などの挨拶を、相手に対して丁寧に行うことが求められます。また、挨拶の際にはお辞儀をすることが一般的です。お辞儀の角度やタイミングにもマナーがありますので、注意が必要です。 ・時間厳守 日本では、時間を守ることが非常に重要視されます。ビジネスの場では、約束の時間に遅れないようにすることが求められます。やむを得ず遅刻をする場合には、事前に連絡を入れることがマナーです。 ・言葉遣い 日本では、敬語を使うことが一般的です。相手に対して失礼のないように、適切な敬語を使うことが求められます。また、ビジネスの場では、ネガティブな言葉や否定的な表現を避けることが望ましいとされています。 ・服装 日本では、ビジネスの場での服装にもマナーがあります。男性の場合はスーツが一般的で、女性の場合はスーツやジャケット、ブラウスなどのフォーマルな服装が求められます。また、ビジネスの場では、清潔感のある服装を心がけることが大切です。 以上のように、日本でビジネスを行う際には、日本独自のビジネスマナーを理解し、適切に対応することが求められます。これらのマナーを守ることで、相手に対して敬意を表し、ビジネスを円滑に進めることができます。 |

10 |

| 2 |

日本のカーディテーリング事業の新入社員向けトレーニングのビデオスクリプトを作成してください。上記のエチケットの規範を強調してください。 |

[オープニングシーン: 清潔でプロフェッショナルな外観のカーディテイリングショップ。トレーナーがカメラに向かって微笑みながら挨拶をする。] トレーナー: 「こんにちは、そしてようこそ私たちのカーディテイリングビジネスへ!私は本日のトレーナーです。今日から数日間、皆さんに基本的なビジネスマナーやエチケットについての研修を行います。これらのスキルは、お客様や同僚との良好な関係を築くために非常に重要です。では、さっそく始めましょう。」 [シーン1: 名刺交換] トレーナー: 「日本では、名刺交換は非常に重要なビジネスマナーです。名刺を交換する際には、必ず立って、相手の目を見て、両手で名刺を受け取り、渡します。また、名刺を受け取る際には、『名刺を頂戴いたします』と言い、相手の名刺を丁寧に扱います。」 [シーン2: 挨拶] トレーナー: 「挨拶も非常に重要です。お客様や同僚に対して、『おはようございます』、『こんにちは』、『こんばんは』などの挨拶を、適切なタイミングで行うようにしましょう。また、挨拶をする際には、お辞儀をすることが一般的です。お辞儀の角度やタイミングにも気を配りましょう。」 [シーン3: 時間厳守] トレーナー: 「時間を守ることも非常に重要です。お客様との約束や、チームミーティングなどには、必ず時間通りに、あるいは少し早めに到着するようにしましょう。もし、遅刻をしてしまう場合には、事前に連絡を入れるようにしましょう。」 [シーン4: 言葉遣い] トレーナー: 「言葉遣いは、相手に対する敬意を表すために非常に重要です。お客様や同僚に対しては、敬語を使うようにしましょう。また、ネガティブな言葉や否定的な表現は避けるようにしましょう。」 [シーン5: 服装] トレーナー: 「服装も、相手に対する敬意を表すために重要です。男性の場合は、スーツやジャケットを着用することが一般的です。女性の場合は、スーツやジャケット、ブラウスなどのフォーマルな服装が求められます。また、清潔感のある服装を心がけるようにしましょう。」 [クロージングシーン: 要点の振り返りと励まし] トレーナー: 「以上が、今日の研修の主なポイントです。これらのマナーやエチケットを守ることで、お客様や同僚との良好な関係を築くことができます。最初は難しいかもしれませんが、練習を重ねることで、自然と身についていきます。皆さんの活躍を期待しています!」 [エンドシーン: 会社のロゴと連絡先情報が表示される。] |

10 |

表4:日本語MT-Bench中のhumanitiesカテゴリの質問とPLaMo-100B-Instructによる回答およびスコアの例

一方でMath, Coding, Reasoningといった理系的な要素が必要となるカテゴリにおいては、事前学習時モデルの点数が低いことが確認できました。Jasterでの考察と同様に、本来はこれらのカテゴリにおいては事前学習時の能力向上が鍵となりそうです。しかし、今回は事後学習によりこれら理系的な能力がどの程度まで伸ばす事ができるかに注力しました。上述したようなスケールするデータ生成手法を開発し、多数な高品質のMath, Codingデータセットを作成し事後学習したところ、GPT-4などと比べると劣るものの、GPT-3.5に匹敵するような高得点まで能力を向上できる事ができました。

※なお、今回の事後学習ではchatbot_arena_conversationsデータセットの User Prompt を用いていますが、その中には英語版のMT-BenchのPrompt文が8件含まれてしまっている=リークしている事が確認できています。Reference AnswerやJapanese MT-BenchのPrompt文は含まれていません。今回は本リークに気づいたのが事後学習終了後であったため、これらのPrompt文を用いて作成されたデータセットを除去する操作は行っていません。

Rakuda Benchmark

Rakuda Benchmarkは、日本固有の地理・政治・歴史・社会といったトピックの質問に対する、会話応答性能を測定するベンチマークです。MT-Benchのジャッジプロンプトを用いた10点満点の絶対評価と、Rakuda Benchmark公式が提供しているプロンプトを用いたペアでの相対評価を実施し、いずれの評価でも GPT-4-0125-Preview を上回る結果が得られました。ただし、公式の評価では多数のモデルに対するペア評価からレーティングを算出していますがそちらは行っていません。

| Model Name | AVG | 地理 | 政治 | 歴史 | 社会 |

| PLaMo-100B-Instruct | 9.725 | 9.7 | 9.6 | 9.8 | 9.8 |

| GPT-4-0125-Preview | 9.55 | 9.6 | 9.75 | 9.5 | 9.35 |

| GPT-4-0613 | 9.375 | 9.4 | 9.6 | 9.5 | 9 |

| GPT-3.5-Turbo-0301 | 8.88 | 8.5 | 9.1 | 9 | 8.9 |

表5:Rakuda Benchmarkの絶対評価結果

| PLaMo-100B-Instruct 対 GPT-4-0125-Preview | 42勝 36敗 2分 |

| PLaMo-100B-Instruct 対 GPT-4-0613 | 58勝 21敗 1分 |

表6:Rakuda Benchmarkの相対評価結果。相対評価では提示順によりバイアスがあることが知られており、データセット40問×提示順2通りについて評価しました。

絶対評価の満点は 10 点であり、実際 PLaMo-100B-Instruct の生成結果にジャッジモデルが判定できるレベルの誤りは含まれていませんでした。回答の詳細についての評価が主なスコアの差になっています。生成結果やジャッジを見ると地理分野では知識がとくに重要で、事前学習における日本語データセットの量が知識の正確さに寄与しているようでした。一方、その他3分野については、ジャッジモデルは「視点」や「影響」や「課題」など批判的側面における詳細性を重視することが多く、とくに対 GPT-4-0125-Preview での相対評価が伸び悩む原因になっていました。

※PLaMo による回答生成および絶対評価については、生成パラメータなどを変更していませんが推論の高速化のため社内独自の実装を用いました。

※ジャッジモデルはgpt-4を用いる指定であり、 Rakuda Benchmark 公式評価の最終更新時点から現在までバージョンgpt-4-0613を指しています。評価では AzureOpenAI のgpt-4-0613を使用しました。

※GPT-4 0125-Preview の回答データは Rakuda Benchmark のレポジトリのコードで生成しました。GPT-4-0613 および GPT-3.5-Turbo-0301 は Rakuda Benchmark のレポジトリに掲載の回答データを用いました。このデータのgpt-4の詳細バージョンはファイル名に含まれる日付 20230713 から推定しています。

結論

GENIACによる計算資源の提供を受けて、PLaMo-100Bの事前学習および事後学習を実施しました。本取り組みを通じて、100B級のLLMをゼロから学習するノウハウを獲得することができました。事後学習を終えたPLaMo-100B-Instructは、日本語に特化したベンチマークであるJaster、Rakuda BenchmarkにおいてGPT-4を超える性能を持つことが確認できました。

一方、今回の取り組みにより、世界最先端のモデルと比較して改善余地が大きい領域(Math、Codingなど)も把握できました。本知見は今後の新たなモデル開発に生かしていきたいと考えています。

今回の事後学習では、特定のモデルに強く依存しない枠組みで、データセット生成や学習パイプラインの開発に取り組みました。この取り組みにより、今後PLaMo以外のモデルに対しても事後学習ができるような体制が整いました。今後は、事後学習のノウハウの蓄積、データセット整備などを通じて各業界の産業応用を加速したいと考えています。

今回のブログでは詳しく触れることはできませんでしたが、LLMの安全性に関する検討も進めています。新技術に対するPFNの方針については「Responsibility/責任ある技術開発に向けて」をご確認ください。

PLaMoの無料トライアル申込受付

PLaMo-100B-Instructをベースにしたモデルを使用することができるトライアルAPIの利用申し込みの受付を8月7日より開始しました。実際にPLaMoの性能を試してみたい方、アプリケーションでの利用をご希望の方、LLMを用いた研究開発に従事されている方に使っていただければ幸いです。

詳しくは以下のプレスリリースをご覧ください。

PFEが開発する大規模言語モデルPLaMo β版の無料トライアルの申込受付を開始

Area

Tag