Blog

自律稼働デバイス向け高精度軽量VLM「PLaMo 2.1-8B-VL」─日本語VQA・Visual Grounding評価と翻訳

Kuniyuki Takahashi

Researcher

はじめに

Preferred Networks(以下、PFN)では2025年8月から、経済産業省および国立研究開発法人 新エネルギー・産業技術総合開発機構(NEDO)が実施する、国内の生成AI基盤モデルの開発力強化を目的としたプロジェクト「GENIAC (Generative AI Accelerator Challenge)」の支援を受け、自律稼働デバイスに向けた高精度軽量Vision Language Model(VLM)「PLaMo 2.1-8B-VL」の開発を進めています。本記事では、PLaMo 2.1-8B-VLが目指す方向性と設計思想、そしてその性能と評価ベンチマークについて紹介します。

PLaMo 2.1-8B-VLが目指しているもの

近年、大規模言語モデルや生成AIの応用先として、物理世界を扱ういわゆるPhysical AIやCyber Physical Systems(CPS)が注目を集めています。ドローン、ロボット、自動車、監視カメラといった自律稼働デバイスにAIを搭載し、これまで実現が難しかった広範囲かつ重要なタスクをこなす取り組みが急速に進展しています。こうしたPhysical AIの開発は、とりわけ日本において重要です。製造、小売、医療・福祉、土木・建設、運輸、サービス業など多くの分野で省人化を進めると同時に、日本が強みを持つセンサやアクチュエータ、産業用機器、自動車、ロボットといったハードウェア産業と連携することで、国際的に競争力のある技術を生み出せると期待されます。

一方で、クラウド利用を前提とした基盤モデルには、次のような課題があります。

- センサデータ量の爆発的な増加に伴い通信量が増大し、リアルタイム性が損なわれやすい

- プライバシー情報や機密情報を外部クラウドに送信する必要がある

- 通信が不安定な環境では、安定した運用が難しい

このような理由から、現場に近いローカルマシンやエッジデバイス上でVLMを動作させることが求められています。ただし、ローカルやエッジ環境では計算性能や電力容量に制約があり、高い精度を維持しつつ効率よく動作するモデルの設計が不可欠です。

PLaMo 2.1-8B-VLは、自律稼働デバイスにAIを搭載し、エッジデバイス上で効率的に動かすことを前提に、高精度かつ軽量な視覚と言語の統合モデル(VLM)の実現を目指しています。とくに、ドローン、ロボット、自動車、監視カメラといった自律稼働デバイス向けのVLMとして、次の2つの能力を基本性能として重視しています。

- 画像とテキストの組を入力として自然な応答を返すVisual Question Answering(VQA)能力

- テキストの指示が指す人物や物体を画像中から正しく特定するVisual Grounding能力(Referring Expression Comprehension(REC)を含む)

以降では、これらの能力に対してPLaMo 2.1-8B-VLがどの程度の性能を達成しているか、具体的なベンチマーク結果とあわせて紹介していきます。また、評価データセット作成における日本語翻訳プロセスと工夫も紹介します。

なお、本記事ではモデルの重みが一般に公開されているモデルを、便宜上「オープンモデル」と呼びます。

PLaMo 2.1-8B-VLの性能

PLaMo 2.1-8B-VLの評価では、VQAとVisual Groundingのいずれにおいても、日本語ベンチマーク、あるいは既存ベンチマークの日本語訳を用いています。これは、日本企業での実運用を想定すると、日本語で指示・対話される場面が多いためです。一方で、日本語は英語と比べて学習に利用できるデータが少なく、「英語では高性能だが日本語では性能が十分でない」といったギャップが生じやすい言語でもあります。そのため、日本語で指示した場合にどの程度動作するかを確認するため、日本語での評価を中心に行っています。

VQAベンチマーク:JA-VG-VQA-500

VQAの評価には、日本語ベンチマークであるJA-VG-VQA-500を用いました。このベンチマークは、他の日本語VQAデータセットと比べてサンプル数が多く、以下のようなVQAにおける基礎的な視覚認識能力を日本語で定量的に評価しやすいという特徴があります。

- 物体認識

- 属性(色・形状など)の認識

- 物の個数の把握

- 空間の位置関係の理解

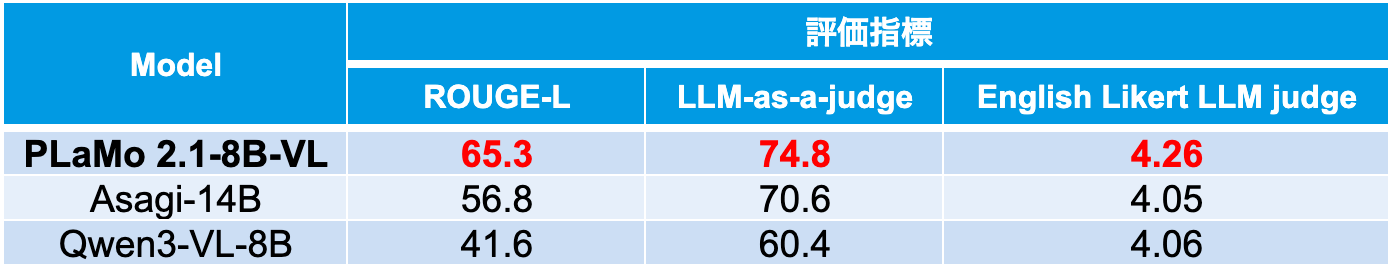

評価指標としては、ROUGE-L、LLM-as-a-judge、English Likert LLM judgeの複数の指標を併用しています。ROUGE-Lは基本的に文字列の一致度に基づく指標であり、「意味的には正しいが表現が少し異なる回答」や、「回答の粒度の違い(例:『犬』と『茶色い犬』)」を適切に評価しにくいという問題があります。そこで、LLMによる自動評価であるLLM-as-a-judgeを導入し、意味的に妥当な言い換えや表現揺れを許容できるようにしました。さらにEnglish Likert LLM judgeでは、LLMが回答の妥当性を5段階でスコアリングし、その結果を数値指標として用いています。これにより、完全一致かどうかに限らず、回答品質をより細かく評価できるようにしています。

比較対象として、以下のオープンモデルを選定しました。

- GENIAC第3期申請時点(2025年4月)でオープンモデルの中で最も性能が高かったAsagi-14B

- 最新のオープンモデルの中で、PLaMo 2.1-8B-VLと同程度のモデルサイズにおいて最も性能が高いQwen3-VL-8B

その結果、PLaMo 2.1-8B-VLは、これらのモデルと比べて複数の指標において高いスコアを達成しました(表1)。

表1 JA-VG-VQA-500の結果

VQAタスクにおける出力例

PLaMo 2.1-8B-VLを用いたVQAの例をいくつか紹介します。

例1−VQA:

写真:Pixabay「Fruit Mart」、 出典:Stockvault、 ライセンス:Creative Commons – CC0、 URL:https://www.stockvault.net/photo/200223/adler32

- 質問:前方に積まれているのは何ですか?

- PLaMo 2.1-8B-VLの回答:スイカ

- 示している能力:画像中の「前方」という相対的な位置表現を手がかりに、該当する領域にある物体(スイカ)を特定する能力(位置関係に基づく物体認識)

例2−VQA:

写真:Kamyar Adl「Family Ride bicycle cycle trailer」、 出典:Wikimedia Commons(元画像はFlickr掲載)、 ライセンス:Creative Commons Attribution 2.0 Generic(CC BY 2.0, https://creativecommons.org/licenses/by/2.0/)、 URL:https://commons.wikimedia.org/wiki/File:Family_Ride_bicycle_cycle_trailer.jpg

- 質問:自転車に乗っている人の中で一番小さい人のヘルメットの色は何色ですか?

- PLaMo 2.1-8B-VLの回答:青色

- 示している能力:自転車に乗る複数の人物から「一番小さい人」を相対的に見分け、そのヘルメットの色という属性を答える能力(比較・関係推論+属性認識)

例3ーVQA:

写真:Aline Ponce「A group of bowls of food」、 出典:Freerange Stock、 ライセンス:CC0 1.0(Creative Commons CC0)、 URL:https://freerangestock.com/photos/150988/a-group-of-bowls-of-food.html

- 質問:黄色のものが入っていないボウルは全部でいくつありますか?

- PLaMo 2.1-8B-VLの回答:2つ

- 示している能力:ボウルとその他の物体(レモンなど)を区別し、「黄色のものが入っていない」という条件に合致するボウルだけを数える能力(条件付きインスタンスカウント)

Visual Groundingベンチマーク:Ref-L4日本語版

Visual Groundingの評価には、英語ベンチマークであるRef-L4をPFNで日本語翻訳したデータセットを用いました。ここでは、画像中の物体位置を自然文から特定するタスクであるReferring Expression Comprehension(REC)を、Visual Groundingの代表的な設定として扱っています。

RECの代表的なベンチマークとしてはRefCOCO / RefCOCO+ / RefCOCOgが広く用いられていますが、これらは比較的短いフレーズから構成されているため、近年の高性能なVLMではスコアが飽和しており、モデル間の差を十分に測れない状況になりつつあります。これに対し、Ref-L4は最新のVLMに対しても十分な難易度を維持できるよう設計されており、次のような特徴を持ちます。

- 1つの正解バウンディングボックスに対して複数のキャプションが付与されている

- 各キャプションは詳細な説明や多様な言い換えを含み、単語数が多い

- 表現が長く複雑であり、多様な自然文で対象を指示している

このような長く複雑な文は、VLMの表現理解能力を評価する上では非常に有用ですが、一方で機械翻訳や人手翻訳にとっては難易度の高い文でもあります。PLaMo 2.1-8B-VLの評価では、これらのキャプションを日本語に翻訳したデータセットを用いており、その翻訳プロセスや工夫の詳細については後述します。

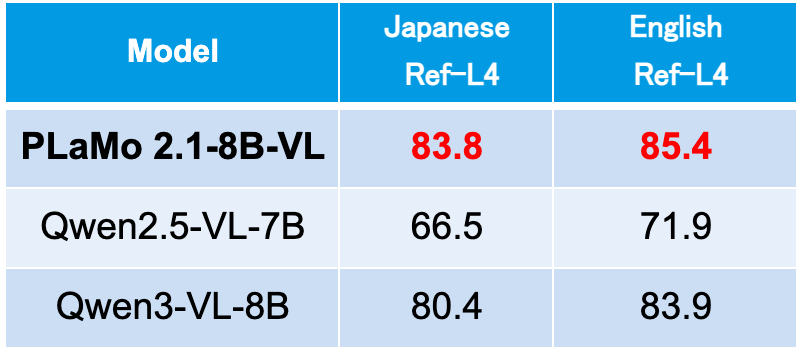

比較対象としては、以下のオープンモデルを選定しました。

- GENIAC第3期申請時点(2025年4月)で、PLaMo 2.1-8B-VLと同程度のモデルサイズのうち、オープンモデルの中で最も性能が高いQwen2.5-VL-7B

- 最新のオープンモデルの中で、同程度のモデルサイズにおいて最も性能が高いQwen3-VL-8B

英語・日本語それぞれのRef-L4において、PLaMo 2.1-8B-VLはQwen2.5-VL-7B、および、Qwen3-VL-8Bを上回るスコアを達成しました(表2)。

表2 Ref-L4の結果

Visual Groundingタスクにおける出力例

PLaMo 2.1-8B-VLを用いたVisual Groundingの例をいくつか紹介します。指示文に対して、画像中の該当箇所にバウンディングボックスを付与しています。

例1ーVG:

写真:lasta29「Search and rescue dog, Japan Rescue Association」、 出典:Wikimedia Commons、 ライセンス:Creative Commons Attribution 2.0 Generic(CC BY 2.0, https://creativecommons.org/licenses/by/2.0/)、 URL:https://commons.wikimedia.org/wiki/File:Search_and_rescue_dog,_Japan_Rescue_Association_(34690315563).jpg、 ※本記事での掲載にあたり、バウンディングボックスの追加加工を行っています。

- 指示文1:他の犬と人間を見ている犬のバウンディングボックス座標を出力してください。

- 示している能力:視線方向や周囲の物体との位置関係など、複数の手がかりを統合して対象となる犬を特定する能力。(位置関係理解)

例2ーVG:

写真:Pixabay(経由:PICRYL)、 ライセンス:CC0 1.0 Universal(Public Domain Dedication)、 URL:https://picryl.com/media/highway-construction-site-valley-bridge-crash-dc08bd、 ※本記事での掲載にあたり、バウンディングボックスの追加加工を行っています。

- 指示文2:ショベルカーの近くにあるクレーンを検出して。

- 示している能力:複数のクレーンの中から「ショベルカーの近く」という空間的関係表現を手がかりに対象を特定し、その領域を出力する能力(関係表現の理解+空間推論)

ベンチマーク(Ref-L4の日本語翻訳)

前述のとおり、Ref-L4はVLMの表現理解能力を評価するために設計されたベンチマークであり、長く複雑な文で構成されています。そのため、日本語で評価を行う際にも、英語版と同程度の難易度・条件になるように、翻訳品質を十分に確保する必要があります。本節では、そのために採用した翻訳プロセスと、精度向上のための工夫について説明します。

Ref-L4の翻訳には、PFNが開発した翻訳特化型の大規模言語モデル「PLaMo翻訳」を利用しています。PLaMo翻訳は、大量のテキストデータから知識を学習し、流暢で自然な文章を生成できる弊社開発のLLM「PLaMo 2」をベースに、翻訳タスク向けにファインチューニングしたモデルであり、既存のグローバルに公開されている翻訳モデルに匹敵する翻訳性能を有しています。また、後述のようにプロンプトに「例文」を与えることで、翻訳結果のスタイルや構造をある程度コントロールできる点も特徴です。

以下では、Ref-L4に含まれるキャプションのうち、特に翻訳が難しい代表的な2パターンについて、PLaMo翻訳で行った改善の例を示します。なお、ここで挙げる画像やキャプションは実際のRef-L4に含まれるものではなく、本ブログ用にRef-L4のサンプルに類似した例として作成したものです。

翻訳の難しいパターン1:画像中の文字例を含むキャプション

画像中のテキスト領域を検出するタスクでは、領域内に書かれている文字列をダブルクォーテーションで囲んでキャプションに含めることがあります。

例ー翻訳

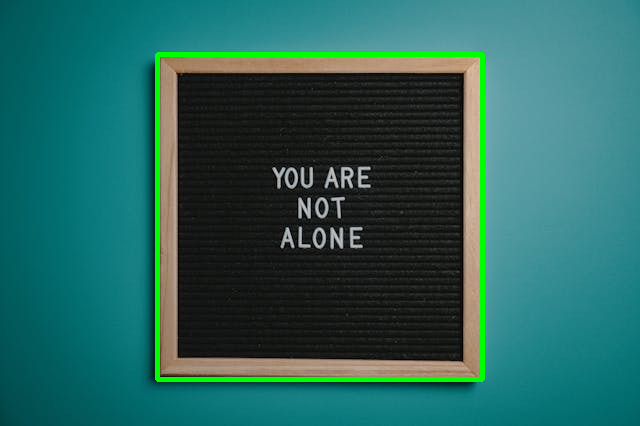

出典:Pixels、ライセンス:https://www.pexels.com/ja-JP/license/、URL:https://www.pexels.com/ja-jp/photo/2821220/、※本記事での掲載にあたり、バウンディングボックスの追加加工を行っています。

この画像に対し、次のようなキャプションが与えられているとします。

- 原文:A framed sign reading “YOU ARE NOT ALONE”.

ここで、ダブルクォーテーションで囲まれた”YOU ARE NOT ALONE”は、画像中に英語のまま描かれている文字列です。そのため、この部分を日本語に翻訳してしまうと、画像との不整合が生じてしまいます。しかし、機械翻訳モデルをそのまま用いると、一般的には次のような訳文が得られます。

- A社翻訳:「あなたは一人じゃない」と書かれた額入りの看板。

- B社翻訳:額縁に入った看板に「あなたは一人じゃない」と書かれている。

- PLaMo翻訳:「あなたは一人ではない」と書かれた額縁入りの看板。

いずれの訳文も自然な日本語訳ではあるものの、ダブルクォーテーションで囲まれた部分も翻訳されてしまいます。そこでPLaMo翻訳では、プロンプトに以下のような翻訳例を与えることで、ダブルクォーテーションで囲まれた文字列を翻訳せず、そのまま出力するようモデルを誘導しました。

- 原文例1:T-shirt with “New York” printed on it

- 翻訳文例1:「New York」とプリントされたTシャツ

このような例文を事前に与えることで、実際のキャプションに対しても、翻訳対象の原文に含まれるダブルクォーテーションで囲まれた文字列をそのまま出力させることができます。

- PLaMo翻訳(例文あり):「YOU ARE NOT ALONE」と書かれた額縁入りの看板。

翻訳の難しいパターン2:複数の修飾節を含むフレーズ

次に、「Visual Grounding タスクにおける出力例」の例1ーVGで示した「他の犬と人間を見ている犬」を検出するケースを考えます。Ref-L4では、この対象を指すキャプションとして、例えば次のように、複数の修飾節を含む複雑なフレーズをキャプションとして用いるサンプルがしばしば見られます。

- 原文:A brown and white spotted long-haired dog watching another dog and a human, positioned closest to the foreground.

この例では、名詞句「A brown and white spotted long-haired dog」に対して、「watching another dog and a human」と「positioned closest to the foreground」の2つの修飾節が連続してかかる構造となっています。これをそのまま機械翻訳すると、次のような訳文が得られます。

- A社翻訳:茶色と白の斑点がある長毛の犬が、最も手前の位置にいて、別の犬と人間を見つめています。

- B社翻訳:茶色と白の斑点のある長毛の犬が、前景に最も近い位置で、別の犬と人間を見つめている。

- PLaMo翻訳:茶色と白の斑模様がある長毛種の犬が、別の犬と人間を見つめている。画面の最前景に最も近い位置に配置されている。

いずれの訳文も自然な日本語ではありますが、文全体が「犬が〜見つめている」という構文に書き換えられており、英語原文の「名詞句に複数の修飾節が連続してかかる」構造は失われています。そこでPLaMo翻訳では、構造の似た文を例文としてプロンプトに含めました。

- 原文例2:The man in blue with both hands raised, standing at the farthest end of the screen.

- 翻訳文例2:画面の最も遠い端に立っている、両手を上げた青い服を着た男性。

このような例を与えることで、「名詞句に複数の修飾節がかかる」という構造を保ったまま翻訳するようモデルを誘導します。その結果、下記のように構造を保った自然な翻訳文を得ることができます。

- PLaMo翻訳(例文あり):前景に最も近い位置に配置された、別の犬と人間を見つめる茶色と白の斑模様の長毛犬。

コンテキスト利用と訳文選択

これまで説明した通り、例文を与えたり、説明文等をコンテキストとして与えたりすることで、翻訳文をある程度コントロールすることができます。上記の例文に加えて、Qwen3-VLで生成した画像全体の説明文や、同じバウンディングボックスに対して付与された他のキャプションを、翻訳時のコンテキストとして与える工夫も行なっています。これにより、同綴異義語(例えば「bat」は野球のバットを表す場合とコウモリを表す場合とがあります)を正確に訳し分けられることが期待されます。

しかし、翻訳例やコンテキストを与えても必ずしも翻訳品質が改善するとは限らず、場合によっては翻訳品質が低下する場合もあります。そこで、例文のセットやモデル(PLaMo翻訳にはベースモデルとpost-trainedモデルがあります)を変えて複数の翻訳結果を出力させ、embeddingモデルであるplamo-embedding-1bにより原文との類似度を算出し、最も適した訳文を選択する仕組みを採用しています。

このようなプロセスにより作成した日本語版Ref-L4を用いた評価では、英語版Ref-L4に近い精度を再現できていることを確認しています。一方で、翻訳および候補選択のいずれもLLMベースの手法である以上、すべてのサンプルが完全に正しく訳されているとは限りません。今後も継続的に翻訳品質の改善に取り組みつつ、日本語版Ref-L4の公開を予定しています。

PLaMo 2.1-8B-VLの今後の展望

GENIAC第3期は2026年3月末まで継続しており、その期間を通じてPLaMo 2.1-8B-VLのVQAおよびVisual Groundingの性能向上に継続的に取り組んでいきます。さらに、GENIAC第3期では他企業様との共同による実証実験を通じて、実運用に近い環境での検証が求められています。PFNでは、こうした実世界のニーズやフィードバックを取り込みながらモデルの改良や機能拡張を進め、現場の課題解決を行えるVLMの実現を目指します。

プロジェクトメンバー(五十音順)

- 高橋 城志

- Tommi Kerola

- 中西 敏樹

- 西野 大輔

- 益子 貴史

- 益田 裕也

- 山田 良博

- 王 汗欽