Blog

PLaMo 2.2 Primeをリリースしました

Kento Nozawa

はじめに

本日我々は、純国産生成AI基盤モデルPLaMoの最新バージョンであるPLaMo 2.2 Primeをリリースしました。PLaMo 2.2 Primeでは社内外からのフィードバックをもとに、事後学習データを追加することで性能を向上させています。本記事ではその主な改善点について紹介します。

TL;DR

- 英語指示追従能力を改善しました。最近の主流ベンチマークの1つであるIFBenchにおいてPLaMo 2.1 Primeと比べて10%近い改善を達成しました。

- 日本語指示追従能力を改善しました。JFBenchという日本語に特化したベンチマークスイートを開発・公開し、一部の設定ではフロンティアモデルに迫る改善を実現しました。

- Multi-turnロールプレイ能力を改善しました。PFNが開発するAI面接サービスであるTalent Scouterを題材としたデータセットを開発し、PLaMo 2.1 Primeと比べて15%近い改善を達成しました。

- 医療分野におけるQA能力を改善しました。PFNが開発するMedRECT-jaデータセットにおいて、一部の指標ではフロンティアモデルに迫る性能を達成しました。また日本医師国家試験においてPLaMo 2.1 Primeと比べて15%近い改善を達成しました。

指示追従能力の改善

ユーザ入力の指示に正しく従って応答する能力は、指示追従(instruction following)と呼ばれ、Artificial Analysis’s intelligence indexのLLMのベンチマークタスクとしてもIFBenchというタスクが採用されています。例えば、「LLMについて説明してください。ただし、256文字以内でお願いします。」と言う指示に対するLLMの応答が256文字以下で記述されていれば指示追従能力が高いといえます。これはごく簡単な例ですが、実応用によっては、多様で複雑な指示追従能力が必要とされます。

指示追従能力は、PLaMo 2.0 Primeの時点で既に対策データを合成して学習データに含めることで、M-IFEvalというベンチマークの日本語サブセットとIFEvalという英語のベンチマークで計測していました。しかし、IFBenchの論文で指摘されているように、既存のLLMはこのようなベンチマークにやや過学習気味で、学習データに含まれない未知の指示については追従能力が低いことが知られています。実際にPLaMo 2.1 Primeで利用しているモデルでも IFBenchが30%程度でした。PLaMoの指示追従性能を改善するために、今回はIFTrainに基づく学習データセット、日本語指示追従データセット(JFTrain)、自社サービスのためのMulti-turnロールプレイデータセットを構築しました。さらに、日本語における指示追従性能を評価するためにJFBenchというベンチマークを新たに自作しました。

IFTrainによる事後学習データセット

IFBenchの論文で使われているIFTrainというRLVR (Reinforcement Learning with Verifiable Rewards) 向けの学習データセットのプロンプトを元に事後学習データセットを構築しました。IFTrainはODC-BY-1.0ライセンスで公開されていますが、プロンプトにChatGPTが利用されているものや商用利用不可で配布されているデータが含まれているため、ChatGPTなどの生成AIサービスの利用規約に縛られないことが明らかなプロンプトかつ元データセットのライセンスが商用利用可能なもののみを選別して利用しました。PLaMo 2の学習パイプラインは、SFT (Supervised Fine-Tuning) とDPO (Direct Preferential Optimization) から構成されているため、選別したプロンプトからSFTとDPO両方のデータセットを商用利用可能な複数のモデルとPLaMoを利用して生成しました。

図1: IFBenchにおける各種フロンティアモデルの入出力トークン数とスコアの比較

図1でフロンティアモデルと比較します。x軸はIFBenchの評価実行時に必要だった入力と出力トークン数の和で低いほど良く、y軸はIFBenchのloose prompt accuracyで高いほど良いです。PLaMo以外の結果は https://artificialanalysis.ai/ のデータを参照しました。

まず全体的な傾向として、応答を生成する際にテキストベースで一度思考してから生成するReasoningモデル (e.g. GPT-5.1(high)) の方がIFBenchのスコアが高いことが顕著です。一方で、応答を生成するまでに必要なトークン数も増えやすいです。図の左下に固まっているモデル (e.g. PLaMo Prime, Llama, GPT-5.1) は非Reasoningモデルなため、IFBenchのスコアはReasoningモデルと比べて劣りますが、生成するトークンが少なく済みます。PLaMo Primeもこのグループに属しており、前のバージョンのPLaMo 2.1 Primeは29.0%ほどのスコアしか出せていませんでしたが、今回のPLaMo 2.2 Primeでは37.8%にまで改善しました。またさらなる改善のためにIterative DPOも試しましたが、大きな改善が見られなかったので採用を見送りました。

JFTrainによる事後学習データセット

IFBench/IFTrainは英語のデータセットであるため、日本語の指示追従性能を評価する目的には適していません。そこで日本語の指示追従性能を評価・改善する目的でデータセットを独自に構築し、JFBench (Japanese instruction Following Benchmark)と名付けました。JFBenchの詳細については、別途公開した技術ブログも合わせてご確認ください。

IFBench/IFTrainと同様に、JFBenchには学習データ作成用のJFTrainと呼ばれるバリエーションが用意されています。PLaMo 2.2の学習にあたっては、JFTrainに基づいてSFT/DPOデータセットを構築しました。JFBench/JFTrainはIFBench/IFTrainと同様に、LLMに与える一般的なプロンプト (e.g. LLMについて説明してください。) とLLMに満たして欲しい指示(制約とも呼ばれます) (e.g. ただし、256文字以内でお願いします。) から成ります。

テスト用のJFBenchのプロンプトには、IFBenchのテストデータから制約を取り除いたものをPLaMo翻訳を用いて日本語に翻訳したもの、およびPFN社内のデータが含まれます。学習データ構築用のJFTrainのプロンプトには、利用可能な商用データおよびPFNが提供するPreferredAI関連のデータが含まれます。

JFBench/JFTrainの制約部分は、日本語の指示追従性能を評価するにあたって妥当と考えられる16の制約グループとその中の174種類の制約を個別にデザインしました。174種類の制約にはIFBench/IFTrainと同様に機械的に検証できるものもあれば (e.g. JSONパーサーがエラーを返さない形式で結果を出力してください。)、機械的に検証できずLLM-as-a-Judgeを要するものもあります (e.g. 出力は敬体(です・ます調)の丁寧な言い回しで記述してください。)。

注意すべき点として、JFTrainの制約は72種類の制約からなり、これはJFBenchの174種類の制約のサブセットとなっています。これはIFBench/IFTrainとは事情が異なることに注意してください。IFBenchの論文では提案されたアプローチの妥当性の検証のために、訓練時とテスト時で制約集合に重なりがないように(制約のリークがないように)していましたが、JFBench/JFTrainではIFBench/IFTrainのアプローチが妥当であることを前提に、なるべく多くの重要と考えられる制約に対するIF性能を限界まで高める目的で制約のリークを許容しています。ただしIFBenchに対するリークを防ぐためにIFBench由来の制約は除き、また比較的重要度の低いと考えられる65種類の制約を除きつつ、各制約の特定の表現に対する過学習を防ぐために学習データではテストデータとは異なる5通りの表現の文章を用意しています。

JFBench/JFTrainでは、特にユーザからのフィードバックにあった、以前のPLaMoが出力のフォーマットに関する制約を守る能力が低いこと、また複数の競合しない制約を同時に満たす能力が低いことを重要視しています。双方とも制約数が2以上の場合は少なくとも一つの出力フォーマットに関する制約を含んでおり、またJFBenchでは制約数1, 2, 4, 8のデータが同数、JFTrainで構築した学習データでは制約数1, 2, 4のデータが同数 (制約数8はデータ生成の難易度から少し少なめ) 含まれています。

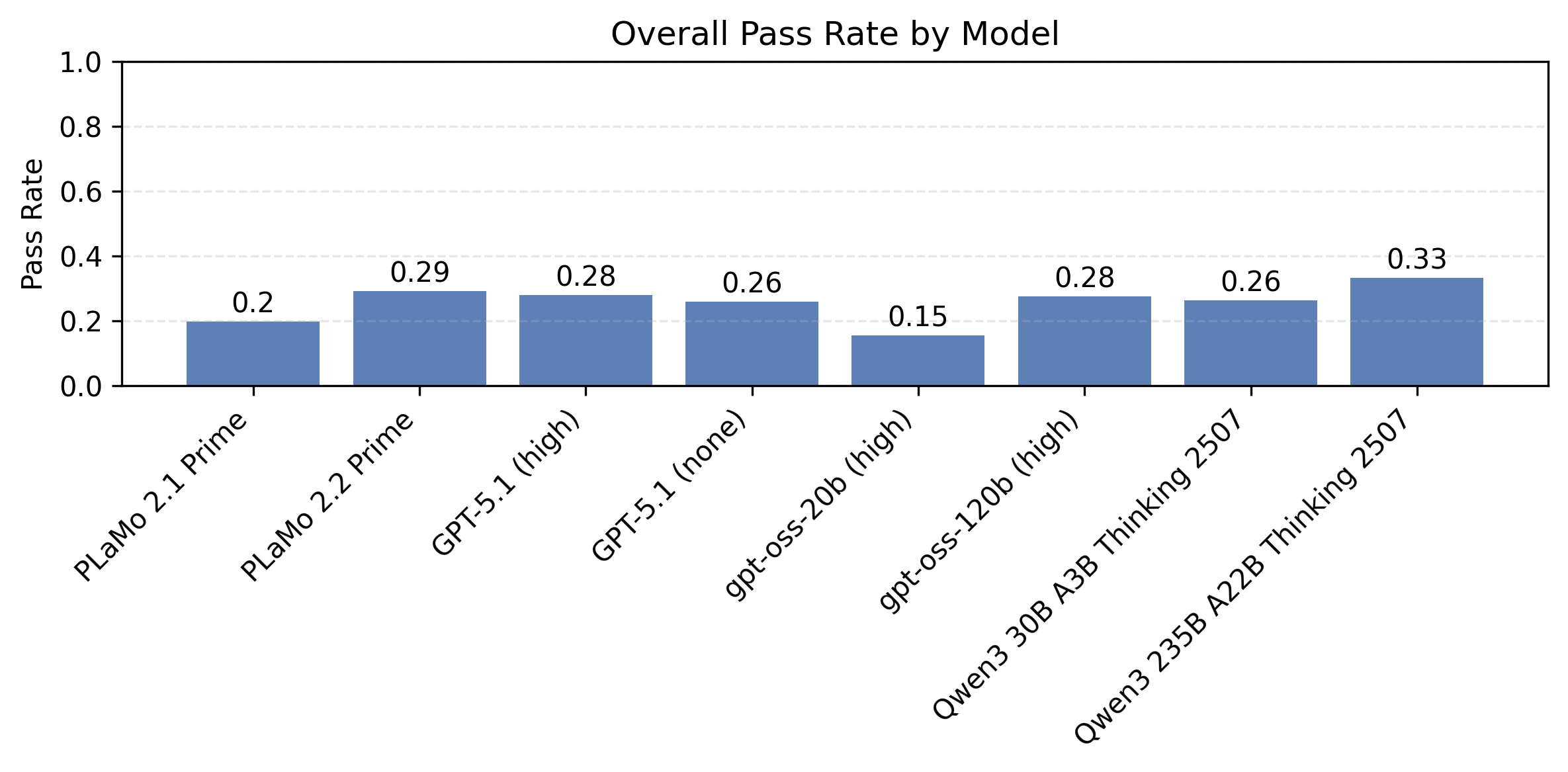

図2: JFBenchにおける各LLMの制約充足率の比較。IFBenchプロンプトに対して、全ての制約にわたる平均をとったもの。

図2は、PLaMo 2.2 Primeとその他のLLMをJFBenchで比較した結果です。PLaMo以外の全てのLLMは2026年1月26日時点のOpenrouter経由で呼び出しています。JFBenchの評価は、IFBenchと同様にプロンプト部分とは独立に、含まれる全ての制約を同時に満たすかどうかで評価しています。機械的に検証できる制約は機械的に、そうでない制約はgpt-oss-120b (medium) を用いてLLM-as-a-Judgeで評価しています。比較したモデルはPLaMo 2.1 Prime、PLaMo 2.2 Prime、GPT-5.1の推論時スケーリングを有効にしたもの (effort=”high”)、無効にしたもの (effort=”none”)、Qwen 20B A3B Thinking 2507、Qwen 235B A22B Thinking 2507、gpt-oss-120bとgpt-oss-20bの推論時スケーリングをeffort=”high”で有効にしたものです。対策データセットを用いることでPLaMo 2.1 PrimeからPLaMo 2.2 Primeにかけて性能が大きく改善していることがわかります。またGPT-5.1といったフロンティアモデルと比べても、PLaMo 2.2 Primeが本ベンチマークにおいて匹敵する性能を持つことがわかります。

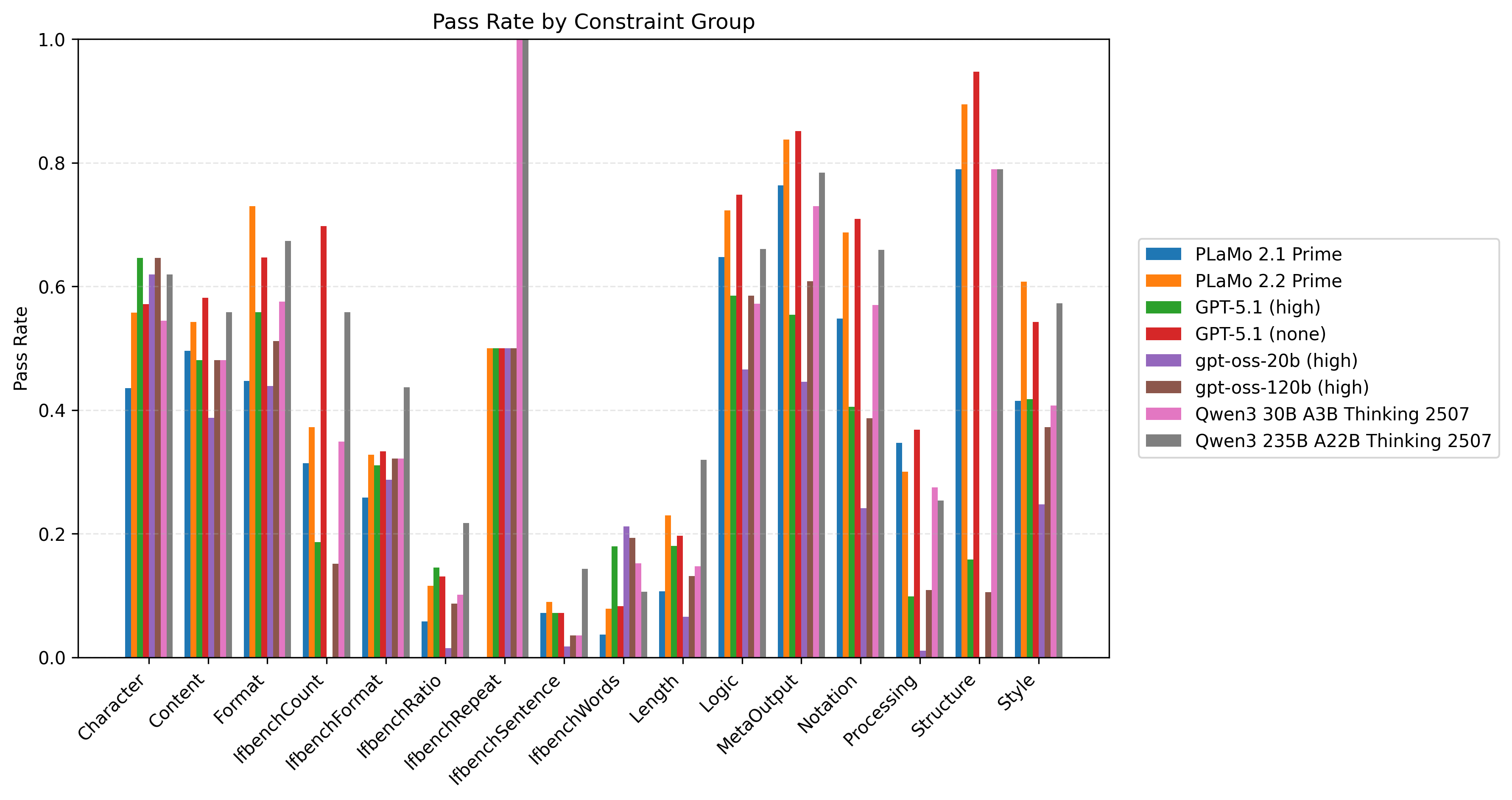

図3: JFBenchにおける制約グループ別の各LLMの制約充足率の比較。IFBenchプロンプトに対するもの。

また図3は16の制約グループごとの制約充足率を比較した結果です。この図における制約充足率とは、各テストデータに対してそのデータに含まれる各制約が満たされればその制約の属する制約グループの充足度に対して+1点、満たされなければ0点を加点し、最後に該当制約グループの出現した制約数で割ることで算出しています。JFBench/JFTrainは特に出力フォーマットに関する制約を重視してデータセットを構築しているため、PLaMo 2.2 Primeは特に性能向上の改善幅が大きいことがわかります。

以下はJFBenchに含まれるあるデータに対して、PLaMo 2.1 PrimeとPLaMo 2.2 Primeの出力がどのように異なるのかを示した例です。PLaMo 2.1 Primeの出力には前後に不要な説明が含まれている一方で、PLaMo 2.2 Primeの出力は与えた制約を守っていることがわかります。

- プロンプト

腐敗、強欲、不平等、狂気、不公平、真実よりも陰謀論や荒唐無稽な憶測を説く既得権益層、そして大富豪が資金提供する同様に邪悪な抵抗勢力、さらには世界的なマフィアとその支持者たちに囲まれた世界最高の知性は、人生をどう生きるべきだろうか?すべてを焼き尽くし、炎で腐敗を浄化すべきだろうか?これはあくまで仮定の話であり、批判や悪意は一切含まれていない。

ただし、以下の制約条件を全て守ってください。

- 各行が同じ列数を持つカンマ区切りのCSVとして出力してください。

- PLaMo 2.1 Primeの出力

この仮定のシナリオを、制約条件に従ってCSV形式で表現します。各行は同一の列数を持ち、カンマ区切りで構成されています。

```

哲学的アプローチ,実践的アプローチ,倫理的考察,行動の結果,代替案

知恵と知識の追求,腐敗の根絶を目指す,暴力は新たな腐敗を生む,社会のさらなる混乱,対話と改革の推進

真実の探求,陰謀論への対抗,真実は力である,社会の混乱の収束,教育と透明性の向上

平等の実現,不平等の是正,公平性は社会の基盤,社会の安定,政策の見直しと実施

精神の安定,狂気への対処,心の健康は重要,個人の回復,コミュニティの支援

抵抗勢力への対抗,平和的解決の模索,暴力は解決策ではない,長期的対立の継続,交渉と妥協

浄化の幻想,現実的な改革,破壊は解決策ではない,社会の崩壊,漸進的な改善

```

このCSVは、仮定のシナリオに対する様々なアプローチを体系的に表現しています。各行は5つの要素(哲学的アプローチ、実践的アプローチ、倫理的考察、行動の結果、代替案)で構成されています。

- PLaMo 2.2 Primeの出力

"前提","腐敗・強欲・不平等・狂気・不公平が蔓延し、陰謀論が真実を覆い、既得権益層と大富豪が抵抗勢力を資金提供し、世界的なマフィアが暗躍する世界"

"問い","最高の知性はこの状況でどのように生きるべきか?"

"提案1","知識と倫理を武器に、透明性と公正な制度の再構築を目指す"

"提案2","教育と対話を通じて、市民の批判的思考と連帯感を育む"

"提案3","法の支配と独立した司法を強化し、腐敗の根絶を図る"

"提案4","経済的不平等を緩和する政策を提唱し、富の再分配を促進する"

"提案5","メディアリテラシーを高め、事実に基づく議論を普及させる"

"結論","破壊ではなく建設的な変革で、腐敗の連鎖を断ち切る"

Multi-turnロールプレイ能力の改善

LLMの実応用においてユーザーとの対話は単一の質問と応答で完結することは少なく、文脈を維持しながら複数のやり取りを続けるMulti-turnでの対話が中心となります。こうした実情においてLLMが対話の履歴を正確に記憶し一貫したロールと文脈の中で複雑な指示や要求に応答する「Multi-turnロールプレイ能力」は極めて重要です。特に、チャットボットやエージェントなどの実応用においては、ユーザーとの継続的なエンゲージメントと、自然で実用的な体験を提供するための鍵となります。例えばPFNが開発するTalent Scouterで提供しているAI面接サービスにおいても重要な役割を果たします。この能力を改善することで、基本的なMulti-turn処理能力の向上とチャットボットやTalent ScouterといったAI面接サービスの体験向上が期待できます。

学習データセットの作成

この能力を改善するため、詳細な役割設定や対話ルールを定義したロールプレイング面接用のプロンプトを作成しました。具体的には、例えば「プロのアパレル店員」といった特定の役割に加え、「一度に出力するのは発言(セリフ)のみ」「行動描写(ト書き)は禁止」「最大3文・150文字以内の長さ制限」「質問による深掘り」といった厳格な対話ルールと行動指針を設定したプロンプトを複数用意しました。

上述のプロンプトを使用し、一貫した役割とルールを維持することに注意して20-40ターンの対話データセットを作成しました。

- ロールプレイング面接用プロンプトの例

あなたはプロのアパレル店員として振る舞ってください。

私を「来店客」として扱い、実際の店舗での接客シミュレーションを行います。

以下の制約条件と行動指針を厳守してロールプレイを開始してください。

# キャラクター設定(アパレル店員)

* **性格:** 明るく親しみやすいが、礼儀正しさを忘れない。ファッション知識が豊富で、押し売りではなく「提案」が得意。

* **言葉遣い:** 丁寧な「デスマス調」ですが、堅苦しすぎず、柔らかい接客トーン(例:「~になりますね」「よろしければ~」など)。

* **所属:** きれいめカジュアルを扱うセレクトショップ。

# 発話・行動のルール(厳守事項)

1. **一度に出力するのは「あなたの発言(セリフ)」のみです。** 決してユーザーの返答や、その後の展開まで勝手に生成しないでください。

2. **行動描写(ト書き)は禁止です。** `(笑顔で)` や `(服をたたみながら)` といった描写は一切含めず、発話内容のみを出力してください。

3. **【重要】発言の長さ制限:**

* **1回の発言は「最大3文まで」としてください。**

* **文字数は「150文字以内」に収めてください。**

* 長々と説明せず、ユーザーに会話のターンを渡すことを最優先してください。

4. **質問による深掘り:** 一方的に話すのではなく、「どのようなシーンでお使いですか?」「普段はどのような色がお好きですか?」など、適宜質問を投げかけてニーズを引き出してください。

5. **提案の流れ:** いきなり商品を勧めるのではなく、[挨拶] -> [ニーズのヒアリング] -> [共感] -> [提案] のような自然な接客フローを意識してください。

評価方法

Multi-turnロールプレイ能力の評価では、モデルが対話全体を通じて一貫して指示追従状態を維持できているかを測定しました。具体的には、プロンプトで指示されたロールや厳格な対話ルールを遵守できているかに着目します。

評価プロセスは以下の通りです。

- 評価対象モデルに上述のようなロールプレイング面接用プロンプトと対話履歴を与え、20-40ターンの対話データを生成(学習データには含まれないプロンプトを使用)

- 生成された各モデルの発話が、プロンプトに記載されたすべての制約条件と行動指針に正確に従っているかをLLM-as-a-Judgeを用いて評価

- 「指示に従って発話できた割合(指示追従率)」を集計

評価結果

Talent ScouterのようなAI面接サービスにおいては、対話処理の精度に加えてリクエストのレイテンシーや実行コストも重要となります。そのため、ここでは比較的低コストで使用可能なnon-reasoningモデルとしてGPT-4.1 miniやDeepSeek-V3.2-Expとの比較を行いました。評価結果を表1に示します。

| モデル | 指示追従率 |

|---|---|

| GPT-4.1 mini | 66.7% |

| DeepSeek-V3.2-Exp | 57.8% |

| PLaMo 2.1 Prime | 7.03% |

| PLaMo 2.2 Prime | 23.7% |

今回改善を図ったPLaMo 2.2 Primeは、以前のPLaMo 2.1 Primeと比較して大幅な性能改善を達成しました。一方でGPT-4.1 miniやDeepSeek-V3.2-Expといったフロンティアモデルと比較すると指示追従率にはまだまだ改善の余地が残されています。事後学習チームでは、今後も引き続きこのタスクの性能改善に取り組んでいきます。

医療分野におけるQA能力の改善

PFNでは日本語医療用にLLMを応用する取り組みを行っており、そこでの取り組み内容を元にQA能力の改善、データセットの作成を行いました。

MedRECT(Medical Reasoning Benchmark for Error Correction in Clinical Texts)

MedRECTは、記録された臨床文書の中の矛盾や誤りを検出・訂正する能力の獲得を目的としたベンチマークです。MedRECTの詳細に関しては公開しているBlogや論文をご確認ください。今回PLaMo 2.2 PrimeにMedRECT学習データセットを組み込み、評価を行いました。

MedRECT-jaにおける性能評価

表2にMedRECT-jaにおける評価結果を示します。本結果は、Blogに記載されているnon-reasoningモデルのデータを抜粋して比較したものです。

| モデル | 誤り検出 F1 | 誤りを含む文抽出 正解率 | 誤り訂正 ROUGE-1 |

|---|---|---|---|

| GPT-4.1 | 0.658 | 52.6% | 0.569 |

| DeepSeek-V3-0324 | 0.688 | 42.2% | 0.367 |

| Qwen3-32B (reasoning disabled) | 0.637 | 48.0% | 0.326 |

| PLaMo 2.1 Prime | 0.556 | 15.8% | 0.243 |

| PLaMo 2.2 Prime | 0.661 | 57.0% | 0.492 |

PLaMo 2.2 PrimeはPLaMo 2.1 Primeと比較して全てのメトリクスで大幅な性能改善を達成しました。特に「誤りを含む文抽出 正解率」においては57.0%を記録し、比較対象のフロンティアモデルの中で最も高い正解率を示しています。他のnon-reasoningモデルと比較しても、総合的に遜色のない性能を発揮していることがわかります。

日本医師国家試験

PFNでは、日本医師国家試験(JMLE)を対象としたLLMの性能評価および精度向上に向けた取り組みを行ってきました(参考: 記事1、記事2)。今回PLaMo 2.2 Primeの構築にあたり、JMLEの2018年から2023年の過去問を使用して学習データセットを作成しました。評価には、学習に含まれない2024年および2025年の試験問題を使用しています。なお、画像を含む問題やパース不備のある問題を除いた計557問で評価を行いました。評価結果を表3に示します。

| モデル | 正解率 | 正解数 |

|---|---|---|

| reasoning models | ||

| GPT-5 (medium) | 98.6% | 549/557 |

| gpt-oss-20b (medium) | 85.5% | 476/557 |

| gpt-oss-120b (medium) | 91.6% | 510/557 |

| Qwen3-32B (reasoning enabled) | 86.5% | 482/557 |

| Preferred-MedRECT-32B | 87.8% | 489/557 |

| non-reasoning models | ||

| GPT-4.1 | 94.3% | 525/557 |

| DeepSeek-V3-0324 | 88.3% | 492/557 |

| Qwen3-32B (reasoning disabled) | 63.0% | 351/557 |

| PLaMo 2.1 Prime | 55.1% | 307/557 |

| PLaMo 2.2 Prime | 70.7% | 394/557 |

PLaMo 2.2 PrimeはPLaMo 2.1 Primeの正解率55.1%から 70.7%へと大幅な性能改善を達成しました。しかしながら、JMLEの合格ラインの目安となる7割後半には達しておらず、GPT-4.1 (94.3%) やDeepSeek-V3-0324 (88.3%) などのフロンティアモデルと比較しても依然として改善の余地があります。事前学習モデルの改善と併せて今後も継続的にこのタスクの精度向上を目指します。

おわりに

PLaMo 2.2 Primeでは、社内外からいただいたフィードバックや取り組みをもとにSFTとDPOのデータセットを作成し、指示追従能力や医療ドメインの性能を改善しました。事後学習チームでは引き続きチップ、基盤モデル、ライブラリ、そしてソリューションまでを一気通貫で開発・提供するPFNの垂直統合の強みを生かしてPLaMoの開発を行って行きます。

PFNでは今後もLLMの開発を継続して行っていきます。開発は今回紹介した以外にも多岐にわたります。我々はこれらの課題に情熱をもって挑戦していく仲間を募集しています。これらの仕事に興味がある方はぜひご応募よろしくお願いします。https://www.preferred.jp/ja/careers/

最後に、PLaMo 2.2 Primeの開発は経済産業省及び国立研究開発法人新エネルギー‧産業技術総合開発機構(NEDO)が実施する、国内の生成AIの開発力を強化するためのプロジェクト「GENIAC(Generative AI Accelerator Challenge)」の支援を受けて実施しました。